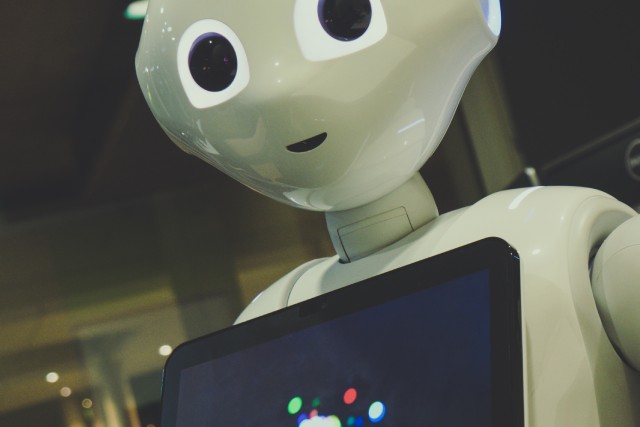

Las personas esperan que la inteligencia artificial mostrada por la ciencia ficción se haga realidad algún día. ¿La verdad? Esta tecnología ya forma parte de la realidad social, empresarial e industrial en la que vivimos desde hace mucho tiempo. Quizás no como en la reconocida película de Steven Spielberg, pero se trata de un fenómeno cultural y fundamento para la robótica que está cambiando el mundo en el que vivimos. Y en el futuro la relevancia de esta tecnología aumentará de forma exponencial con el desarrollo de otras paralelas como y Iot, Big data.

Descubre con nosotros qué es la inteligencia artificial, cómo funciona, algunas de sus aplicaciones y ejemplos de empresas reales, peligros, su historia y futuro. ¡Disfruta!

Los avances tecnológicos, la digitalización, el big data y el internet de las cosas nos siguen acercando a lo que John McCarthy definió en 1956 como inteligencia artificial (IA). En una conferencia realizada en Dartmouth, este experto señaló que esta disciplina se encarga de sentar las bases para la creación de máquinas inteligentes, en especial programas que simulan la inteligencia humana.

De forma similar, otros la consideran una rama de las ciencias de la computación que está enfocada en la construcción de sistemas capaces de llevar a cabo tareas que requieren inteligencia. Esto implica que estos entornos computacionales se apoyan en diferentes tecnologías, como el machine learning (ML) y el deep learning para seguir evolucionando dentro de la industria.

Desde una perspectiva más específica, otros especialistas coinciden en definir la IA como una combinación de algoritmos avanzados que pueden ser programados para crear sistemas inteligentes. Es decir, agentes dentro de máquinas que presentan rasgos de inteligencia humana, tienen la capacidad de percibir su entorno y de adaptarse de forma exitosa para realizar tareas simples o complejas.

Cualquier punto de vista que se tome de esta ciencia, irá transformándose a medida que las TICs sigan desarrollándose y el futuro nos acerque más al objetivo de la inteligencia artificial. Hoy día esta serie de tecnologías abarcan la robótica, mecatrónica y varios procesos de digitalización empresarial. Con la llegada de los macrodatos, su importancia se ha hecho más presente que nunca.

Cuando tratamos de explicar el funcionamiento de la AI, tenemos que remitirnos primero a responder qué hace a los programas y máquinas inteligentes. Este entendimiento parte de la definición de inteligencia que ya hemos abarcado, los tipos de IA que veremos más adelante y las categorías que enmarcan su implementación en diversos contextos.

Tomando lo último como referencia, encontramos 2 escenarios principales para comprender mejor esta disciplina:

También llamada IA débil, son los sistemas que pretenden simular la inteligencia humana y operan dentro de un contexto limitado. Esta clase de funcionamiento se enfoca en hacer una sola tarea con eficiencia y rendimiento excepcionales. Puede que estas máquinas parezcan muy ingeniosas, pero en realidad están operando bajo controles que están lejos de una inteligencia humana básica.

Esta clase de inteligencia artificial es la que ha tenido más éxito en su aplicación práctica, por ello influyen en casi todo lo que hacemos. Esta adopción ha significado una serie de disrupciones y avances tecnológicos en los últimos 10 años que han contribuido al desarrollo social, económico y empresarial. Entre sus ejemplos más reconocidos, tenemos: coches autónomos, asistentes virtuales (Siri, Alexa, etc.), software de reconocimiento facial, plataformas de publicidad con IA y mucho más.

Este funcionamiento está más cercano al objetivo de la inteligencia artificial que vemos en las películas, como androides y robots parecidos a los humanos. Es considerada como IA fuerte porque estas máquinas pueden actuar como las personas, reaccionar a su entorno y resolver toda clase de problemas usando su inteligencia.

La producción de sistemas humanoides o robots con capacidades sobrehumanas no es algo que vaya ocurrir en un futuro tan cercano. Mientras que lograr un nivel de inteligencia parecido al de las personas sería un logro sin precedentes, hay muchos obstáculos para lograr la AGI. De acuerdo a Stuart Rusell y Peter Norvig, la búsqueda de un algoritmo que pueda actuar y aprender en cualquier entorno no es nueva, pero existe gran dificultad para diseñar un sistema con amplias habilidades cognitivas.

La creación de máquinas que simulan la inteligencia humana a través de las nuevas TICs y otras tecnologías no es una ciencia perfecta. Para entender mejor la IA, tenemos que revisar sus ventajas y desventajas:

Los sistemas basados en algoritmos de inteligencia artificial funcionan a partir de registros y decisiones anteriores. Por ello, máquinas y aplicaciones tienen la capacidad de resolver problemas en menor tiempo y con una tasa más baja de error. Por ejemplo, las empresas utilizan asistentes digitales o virtuales que están programados para dar la mejor atención posible a los usuarios.

A diferencia de los humanos, los robots creados con IA pueden ser diseñados para funcionar en ambientes normales o extremos sin necesidad de descansos. Pueden trabajar por su cuenta por largas horas, de forma continua y sin distracciones. Ya que su eficiencia no está influida por factores internos o externos, pueden ejecutar tareas difíciles y repetitivas con menor desgaste.

Otra ventaja de la inteligencia artificial está en la ausencia de emociones y el uso de mayor racionalidad. Esta característica le permite a estos sistemas tomar decisiones de manera eficiente sin vacilar. Como no tienen un lado sentimental, pueden ir desarrollando una lógica más depurada y producir con mayor eficiencia. Un ejemplo de ello lo vemos en el sector sanidad, donde las herramientas AI han mejorado los tratamientos y reducido el riesgo de diagnósticos falsos.

Ya que estas máquinas o robots están programados con una serie de órdenes, sus decisiones no cambian con el paso del tiempo al menos que se les dé otras directivas. Aunque acumulen gran cantidad de información, es procesada de una forma diferente a la inteligencia humana. Por esta razón se les complica adaptarse para responder en ambientes dinámicos (por el momento).

No importa qué tan inteligente sea un sistema artificial, difícilmente podrá parecerse a una persona. Como está diseñado para ser racional, esto implica que no tiene valores morales ni emociones. Tampoco posee habilidades de juicio ni puede distinguir entre aquello lo ético o legal. En definitiva, no distingue lo bueno de lo malo y cualquier situación inesperada puede alterar su funcionamiento correcto.

Como ejemplo: Imagina que vas con tu coche por la calle y se cruza un niño. Tu instinto te llevaría a dar un volantazo con el riesgo de tener un accidente. Ahora imagina que vas en un coche que se conduce mediante inteligencia artificial. Este coche calcularía el riesgo de accidente en función de su entorno y quizás llegaría a la conclusión de que se corre menos riesgo atropellando al niño, porque se reduce el riesgo de tener un accidente con mayores consecuencias.

No es un secreto que la implementación de esta tecnología en empresas, startups y otros negocios puede ser cara. Por ser máquinas o programas complejos, su instalación, mantenimiento y reparación cuestan bastante dinero. Además, requieren de actualizaciones periódicas y si llegan a fallar por completo, los gastos de reemplazo o recuperación son bastante altos.

Una forma de entender la IA desde cero es tomando en cuenta los conceptos incluidos en la obra escrita por Peter Norvig y Stuart Rusell: “Inteligencia artificial: un enfoque moderno”. Catalogada como una referencia obligada dentro de este campo en pleno desarrollo, los autores establecen 4 tipos AI, que resumiremos así:

La evolución del big data ha representado un avance tecnológico que calza de manera ideal con los experimentos y aplicaciones asociadas con las inteligencia artificial. Los modelos de machine learning se alimentan de datos para ser mejores, lo cual se consigue con los macrodatos. Es una relación recíproca donde la AI depende de esta información para ensayos exitosos y al mismo tiempo ayuda a empresas e investigadores aprovechar el big data.

Existe una serie de retos que deben ser superados para que estas tecnologías se complementen con mayor afinidad. Este emparejamiento crea una serie de necesidades nuevas en temas como gobernanza, preparación de datos e infraestructura, por nombrar algunos. Sin embargo, la integración de IA y ML cumplen la función de lidiar con estos problemas complejos.

Los avances tecnológicos impulsados por las TICs, la digitalización e incluso por startups hacen que la inteligencia artificial esté más presente en nuestras vidas. Muestra de ello son los bots integrados a nuestros dispositivos favoritos y motores de búsqueda, la inclusión de asistentes virtuales manejados por voz y el reconocimiento biométrico integrado a aplicaciones o aparatos.

La presencia de la AI también ha sido impulsada por tecnologías como el internet de las cosas y el big data, que permiten tanto la generación como la gestión de macrodatos. Estas cantidades masivas de información están siendo aprovechadas en diferentes ámbitos para ofrecer mejores soluciones y facilitar nuestra convivencia mediante entornos más inteligentes.

Dentro de sus múltiples aplicaciones, podemos destacar:

En este momento del desarrollo de la IA es posible encontrar muchos ejemplos representativos dentro de la industria 4.0. Con la evolución del Big Data y el IoT, la digitalización empresarial empieza a consolidar su innegable utilidad. Tomando como referencia algunas de las compañías más importantes del planeta, encontramos lo siguiente:

Es cierto que cualquier tecnología mal empleada representa un riesgo para la humanidad y su eventual supervivencia. A medida que la IA se vuelve más ubicua y sofisticada, diversos expertos advierten sobre lo que podría salir mal.

En Portugal, el reconocido físico Stephen Hawking ha dicho sin tapujos que el impacto de la inteligencia artificial podría ser cataclísmico, al menos que su rápido desarrollo cuente con regulación ética. De igual forma, el emprendedor Elon Musk ha expresado de forma ominosa en Texas: “Estoy muy cerca... de lograr lo más avanzado en AI. Y esto me causa pánico”.

Ante estas advertencias, podemos resumir los principales riesgos asociados con esta ciencia así:

Entre los usos maliciosos de la IA, destacan los peligros potenciales contra la seguridad digital, política y social mediante máquinas entrenadas para hackear, drones con armas, perfilamiento u otras tácticas. Un ejemplo claro de la violación a la privacidad es China, que ha implantado el reconocimiento facial en escuelas, organismos, oficinas y más.

Este uso totalitario también aplica para los “deepfakes de audio y video que sirven para manipular voces o clips. Mientras que la primera ya está teniendo cierto impacto, la segunda podría ser más peligrosa. Mediante herramientas IA, cualquiera podrá alterar un video de una persona conocida para que exprese ideas de odio, racismo o violencia y además luzca bastante convincente.

La preocupación principal en el mercado laboral apunta al grado de automatización y digitalización empresarial. Un estudio indica que un 70% de las labores de 36 millones de personas podrían ser reemplazadas tarde o temprano. Otros expertos señalan que el sistema consolidado de bajos salarios y poco desempleo sufrirá cambios ante una fuerza de trabajo robotizada.

Ciertamente, no se sabe cuántos empleos puede generar la implementación de la inteligencia artificial. El problema es que muchos de ellos solamente estarán disponibles para los más educados entre el personal reemplazado. Incluso los profesionales altamente capacitados podrían ser sustituidos, en especial quienes trabajan en medicina, leyes y contabilidad.

El problema en este sentido es que cualquier país con poder militar tiene la capacidad de iniciar una carrera de armas cuyo desenlace inevitable es el armamento autónomo. Sería mucho más barato que el nuclear, fácil de producir en masa y estaría en todas partes. Además, podrían ser usadas por terroristas o dictadores para desestabilizar naciones, asesinar, hacer matanzas selectivas y más.

La implementación de la AI puede ampliar más la brecha entre quienes tienen mayor capacitación que otros. El desarrollo de estas tecnologías incluye un sesgo algorítmico e informacional porque están a cargo de personas. Los investigadores de inteligencia artificial suelen ser de cierta raza, con un alto nivel socioeconómico y de género masculino. Dentro de su comunidad, es más difícil considerar los grandes temas globales y su ilusión de objetividad no está enfocada en comprender la dinámica social.

Podemos decir que la aparición de seres artificiales puede remontarse a la época de la antigua Grecia. No obstante, los verdaderos fundamentos de la IA moderna los encontramos a mediados del siglo pasado, gracias a la labor de investigadores que dieron esos primeros pasos. Para tener una mejor perspectiva de esta evolución, describiremos de forma cronológica los hitos más importantes:

En medio de la II Guerra Mundial, Walter Pitts y Warren McColough publican (1943) la obra: “A logical calculus of ideas immanent to nervous activity”, que representa un modelo matemático para construir una red neuronal. A esto le seguiría la obra de Donald Hebb (1949): “The organization of behavior: a neuropsychological theory, que propone la tesis sobre cómo las conexiones neuronales se fortalecen mientras más se usan.

Aparece la publicación “Computing machinery and intelligence” (1950) de Alan Turing, uno de los padres más influyentes de la IA. En este texto está la prueba Turing para determinar si una máquina posee inteligencia. Ese mismo año surge SNARC, el primer ordenador con red neuronal e Isacc Asimov concibe las 3 leyes de la robótica.

Para 1952, Arthur Samuel desarrolla un programa para jugar a las damas que posee autoaprendizaje. A esto le siguió el acuñamiento del término inteligencia artificial por John McCarthy en una conferencia de 1956, dando origen oficial a esta ciencia. Este científico luego desarrollaría el lenguaje de programación LISP (1958).

A principios de este período (1963), el mismo McCarthy funda el Laboratorio de IA en Stanford. Y más adelante, aparecen los primeros programas expertos exitosos para diagnosticar infecciones sanguíneas, como Dendral y Mycin. También crean el lenguaje de programación Prolog y se para la investigación en el campo por los reportes “Lighthill” y ALPAC.

En 1980, surge el XCON (o R1), el primer sistema comercial experto, reactivando la inversión en AI. Luego Japón lanzaría (1982) el proyecto FGCS para desarrollar un rendimiento tipo súper ordenador, al cual le seguiría la Iniciativa de Computación Estratégica de EEUU (1983). Durante 1985, compañías como Lisp Machines y Symbolics se dedican a crear computadoras especiales con este lenguaje, pero en 1987 aparecen otras alternativas más baratas, colapsando dicho mercado.

El derrumbe del mercado de Lisp fue seguido por la terminación del proyecto FGCS (1992), al igual que el cierre de la Iniciativa de Computación Estratégica estadounidense (1993). Durante la Guerra del Golfo sale a luz el DART y luego en 1997 la computadora Deep Blue vence a Garry Kasparov, el entonces campeón mundial de ajedrez.

Otros hitos importantes, son:

La combinación de big data, internet de las cosas, machine learning, deep learning e inteligencia artificial está cambiando la forma de hacer negocios, interactuar y otros aspectos humanos. De hecho, la consultora Gartner estima que este año, el 85% de la gestión de clientes se hará con herramientas de IA. Este mercado puede llegar a representar una inversión de 127 mil millones de dólares para 2025.

Por otra parte, hay voces como la de Stephen Hawking, quien predice que las máquinas están destinadas a superarnos en menos de 100 años. Lo mismo piensa Nick Bostrom, filósofo que augura una posibilidad del 90% de que entre 2070 y 2095 existan robots o sistemas humanoides tan inteligentes como nosotros. Por ahora, la inteligencia artificial conforma una serie de herramientas y tecnologías que nos permiten avanzar hacia un futuro lleno de posibilidades.

No hay duda de que aprender IA desde cero puede ser una habilidad que puedes explotar en un corto plazo para hacer algo que te gusta y obtener grandes beneficios. Para ello, es importante conocer el software de inteligencia artificial Python y el lenguaje C++. Su dominio te permitirá manejar librerías, estructuración de datos, integrar desarrollo, aplicar ML y mucho más.

Además, en la actualidad existen máster, grados, cursos y libros para aprender a programar inteligencia artificial que puedes conseguir online u offline. El aprendizaje de esta disciplina y sus ramas te sirven para dominar la digitalización empresarial y tener un gran futuro dentro de la industria 5.0.